Als das Internet noch ein unberührter, unregulierter, komplizierter und unüberschaubarer Spielplatz für Nerds war, habe ich meine Mutter in meinem Kinderzimmer an meinem PC erwischt. Dort nämlich stand der einzige Computer in der Wohnung, damals noch mit piependem 56k Modem. Sie versuchte herauszufinden, welche Kandidaten noch im Big-Brother-Haus sind. Dazu tippte sie „Welche Kandidaten sind noch …“ in das Eingabefeld der Suchmaschine, als ich sie belustigt unterbrach und ihr meine deutlich überlegenen Internet-Skills demonstrierte. Ich löschte ihre aufwendig getippten Wörter und googelte schlicht „Big Brother“. Zwei bis sieben Klicks später gab es die gewünschte Antwort.

Klicke auf den Button, um diesen Inhalt zu laden.

Ok, ich gebe zu: Keine Ahnung, ob sich die Geschichte wirklich so abgespielt hat. Genauso gut könnte es auch mein Vater mit „Formel 1“ gewesen sein. Und vielleicht hat er nicht bei Google, sondern bei Yahoo, T-Online oder AOL gesucht. Spielt aber auch keine Rolle. Wer etwas im Internet finden wollte, hat das noch vor gar nicht langer Zeit am besten mit einem einzigen guten Suchbegriff gemacht. Suchanfragen mit vielen Wörtern, insbesondere mit Wörtern, die sehr häufig vorkommen, waren ungeeignet, weil immer nach einzelnen Wörtern innerhalb einer Suchanfrage gesucht wurde.

In diesem Beitrag zeige ich euch, wie BERT und Natural Language Processing das Googeln und unser Verhalten im Internet verändern.

Suchanfragen in ganzen Sätzen

Wenn ich heutzutage nachgucken will, ob ich eine Jacke mitnehmen sollte (also wie kalt es am Abend sein wird), nutze ich immer noch eine Suchanfrage wie „Wetter Koblenz“ statt „Wie kalt wird es heute Abend in Koblenz?“ oder „brauche ich heute Abend eine Jacke?“. Das ist gelernt, so habe ich schon immer gesucht … und das werde ich wohl nicht so schnell ändern.

Aber bei meiner heutigen Suche nach neuen Fahrradreifen habe ich folgende Suchanfrage verwendet: „Welche Reifen passen auf die dt swiss 511db?“. Selbstverständlich hätte auch „Reifenbreite dt swiss 511db“ funktioniert. Beide Anfragen liefern eine passende Antwort, ohne dass ein weiterer Klick nötig wäre.

Suchergebnis für „Welche Reifen passen auf die dt swiss 511db?“

Das ist technisch sehr interessant, aber wenn wir ehrlich sind, ist es soweit nichts wirklich Neues. Diese Suchanfragen in ganzen Sätzen haben sich zunehmend in unser Suchverhalten eingeschlichen und gehören nun zum Alltag. Heute würde ich meine Mutter nicht mehr auslachen.

BERT versteht den Kontext

Was bedeutet BERT eigentlich? Die vier Buchstaben stehen für Bidirectional Encoder Representations from Transformers.

Natural Language Processing (NLP), also die Verarbeitung natürlicher Sprache, ist schon lange ein relevanter Bereich in der Informatik. Zahlreiche Algorithmen und Verfahren aus der Forschung beflügeln bereits Suchmaschinen, Chatbots oder Sprachassistenten. Obwohl die vielfältigen Einsatzmöglichkeiten und Vorteile natürlich sprachlicher Kommunikation auf der Hand liegen, ist die Bedienung solcher Systeme häufig noch unbefriedigend.

Die Dinger verstehen einfach nicht was man von Ihnen will[tweet]

Tatsächlich ist der unberücksichtigte Kontext einzelner Wörter, Satzteile oder ganzer Sätze oft das Problem. BERT gelingt es mit bidirektionaler Erkennung von Beziehungen zwischen einzelnen Textstellen, diesen Kontext besser zu verstehen als bisherige NLP-Verfahren. Daher auch das B in BERT. Klingt schrecklich kompliziert, ist es auch. Aber den Ablauf zu verstehen, ist ganz einfach:

Anstatt eine Textpassage Wort für Wort, von Anfang bis Ende zu analysieren, wirken sich alle Wörter auch auf die Bedeutungen vorangegangener Wörter aus. Zum Beispiel kann dank BERT besser zwischen „Bank zum Sitzen und Bank zum Geld abheben“ unterschieden und der Begriff „Bank“ je nach Kontext mit einer anderen Bedeutung belegt werden. Bei so plumpen Beispielen wie dem Vorangegangenem wirkt sich das in der Realität nicht aus. Google muss nicht verstehen was eine Bank ist, um hier das gewünschte Suchergebnis zu finden.

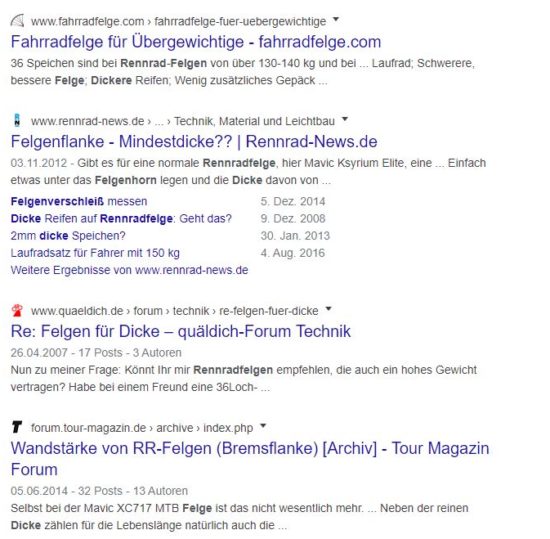

Um an dieser Stelle nicht die vielfach zitierten Originalbeispiele von Google zu kopieren, habe ich für euch versucht, selbst eins zu konstruieren: Obwohl die Suchanfragen „Rennrad Felge für Dicke“ und „Dicke Rennrad Felge“ sehr ähnlich sind, ist Google in der Lage, den feinen kontextuellen Unterschied zu erkennen und die Suchergebnisse entsprechend zu priorisieren.

Suchanfrage 1: „Dicke Rennrad Felge“

So fällt das Suchergebnis bei Google für „Dicke Rennrad Felge“ aus.

Suchanfrage 2: „Rennrad Felge für Dicke“

Abweichendes Suchergebnis für „Rennrad Felge für Dicke“.

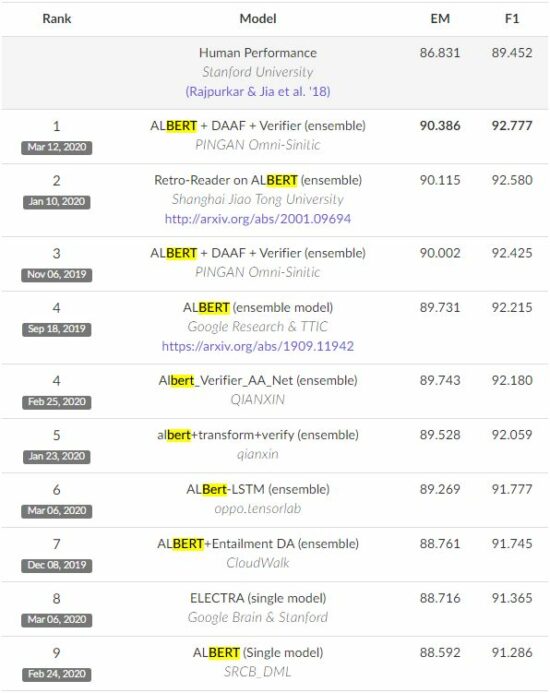

Natürliche Sprache in der Mensch-Maschine-Interaktion

Computer sind nun also in der Lage, komplexe Sätze zu verstehen und diese Sätze in den richtigen Kontext einzuordnen. Das sind zwei wesentliche Ingredienzen von aktuellen NLP-Systemen und relevant für das vollständige Verständnis natürlicher Sprache. Aus diesem Grund sind eure Website-Texte auch so wichtig … dazu gleich mehr! Es gibt Verfahren zur Bewertung der Qualität von solchen Systemen. Häufig wird das „Stanford Question Answering Dataset“ (SQuAD) dafür verwendet. SQuAD ist eine Sammlung von Fragen und einer Wissensdatenbank, aus der die Antworten hervorgehen. Das Testverfahren sieht vor, dass mittels NLP Antworten zu den Fragen in der Wissensdatenbank gesucht werden. Die Anzahl der gefundenen relevanten Antworten (precision) im Verhältnis zu allen relevanten Antworten (recall) bildet den F1-Score, nach dem die NLP-Systeme bewertet werden.

Aktuelles Leaderboard des SQuAD 2.0 Tests (Stand 18.03.2020)

Obwohl NLP-Systeme vor BERT schon F1-Scores um die 90 % hatten und somit besser abgeschnitten haben als Menschen, zeigt das aktuelle Leaderboard des SQuAD-Tests, dass die meisten führenden NLP-Systeme auf BERT basieren. Was wiederum dadurch die riesigen Fortschritte gegenüber früheren NLP-Systemen bestätigt. Möglich ist das, weil Google die Technologie als „Open Source“ veröffentlicht hat. Seit der Veröffentlichung haben viele Forschungsteams die Technologie weiterentwickelt und so das Potential von BERT weiter ausgeschöpft als Google selbst. Weitere technische Details zu BERT findet ihr im entsprechenden Artikel im offiziellen Google AI Blog.

Was für Auswirkungen hat Google BERT?

Jetzt sollte es besonders spannend für euch werden: In Bezug auf SEO-Strategie und Google-Ranking gilt nach wie vor, dass qualitativ hochwertiger und vor allem relevanter Content im Mittelpunkt stehen sollte. Die Interpretation von Suchanfragen und die Bewertung von Webseiten wird immer besser, beziehungsweise menschenähnlicher. Wer bislang nicht getrickst hat, um sein bereits sehr gutes Google-Ranking aufrecht zu erhalten, sollte keine großen Auswirkungen spüren und jetzt auch nicht auf Teufel komm raus mit Tricksereien anfangen. Diejenigen unter euch, die schlechte SERPs aufweisen, haben allerdings einige riesige Chance!

Tipp: Gute und leicht umzusetzende Hilfestellungen, mit denen auch ihr eure Rankings verbessern könnt, findet ihr in unserem Artikel „Warum SEO-Texte wirklich wichtig sind“ sind.

Wie ich im vorherigen Abschnitt beschrieben habe, hat BERT schon jetzt einen erheblichen Beitrag zur Verbesserung der Mensch-Maschine-Interaktion und somit zum Technologischen Fortschritt geleistet. In der Praxis wird sich dieser Fortschritt in diversen Anwendungen zeigen. Allem voran das Verständnis natürlichsprachiger Suchanfragen in Suchmaschinen.

Mobile Nutzung profitiert von BERTs Einfluss auf Voice-Search

Wichtig ist für euch dabei zu wissen, dass natürlichsprachige Suchanfragen besonders für Voice-Search relevant ist. Spätestens seit Alexa, Siri, OK Google und Cortana beobachten wir, dass zahlreiche praktische sprachgesteuerte Anweisungen die Nutzung von diversen Geräten angenehmer macht. Am häufigsten wird Voice-Search am Handy verwendet. Was auch klar ist, da gerade die handlose Steuerung deutlich bequemer ist. Mit steigender Qualität der Suchergebnisse bei gesprochenen Anfragen wird auch deren Beliebtheit zunehmen und neue Anwendungsbereiche erschlossen werden.

Die vorangehenden Beispiele zeigen, dass die Nutzung von Spracheingaben auch eine Sprachausgabe und somit die Optimierung von Web-Inhalten für eine Sprachausgabe interessant macht. Seit 2018 können mit der Schema.org-Property Speakable Web-Inhalte für die Sprachausgabe aufbereitet werden. Der folgende Tweet zeigt zwar, dass Google den Begriff Voice Search Optimization offenbar nicht ernst nimmt. Dennoch finden wir, dass man sich mit der strukturierten Aufbereitung von Webinhalten für die Sprachausgabe unter bestimmten Bedingungen beschäftigen sollte.

Mit dem Laden dieses Inhalts akzeptierst du die Datenschutzerklärung von Twitter.

Mehr erfahren

Erkenntnisse und Fragen zu den Themen BERT und SEO

Wir haben aus der Recherche für diesen Artikel auf jeden Fall einige Erkenntnisse und Fragen für die Zukunft mitgenommen, die wir mit euch teilen möchten:

- Hinterfragt eure Methoden sowie Herangehensweisen und Werkzeuge ständig und optimiert, sofern Bedarf besteht

- Überprüft, wie gut sich eine Keyword-Recherche mit natürlich sprachigen Suchanfragen vereinbaren lässt

- Klärt für euch, was ihr tun könnt, um eure Texte und Inhalte für die Suche mit Sprachassistenten zu optimieren

- Erarbeitet, wie ihr und eure Kunden von den Fortschritten in der Mensch-Maschine-Interaktion profitieren könnt

- Findet für euch heraus, welche technischen Hilfsmittel wie Text-Analyse-Tools bei der Erstellung von qualitativ hochwertigem Inhalt unterstützen können

Wenn euch das jetzt wie ein zu großer Berg erscheint, sprecht uns einfach an. Gern erklimmen wir BERT mit euch gemeinsam.